इस एपिसोड में हम सीखेंगे की WordPress Robots.txt for SEO यानी अपने Blog के SEO को और बेहतर बनाने के लिए robots.txt फाइल को ऑप्टिमाइज कैसे करें।

robots.txt फाइल के मदद से ही सर्च इंजन के रोबोट्स को ये पता चलता है कि हमारे साइट पर कौन कौन से पेज को एवं किस हिस्से को Crawl करना है और किस हिस्से को Crawl नहीं करना है।

हम जब भी एक WordPress बनाते हैं तो वर्डप्रेस डिफ़ॉल्ट रूप से हमारे साइट के लिए रोबोट डॉट टीएक्स टी फाइल उत्पन्न कर देता है लेकिन ये एक आदर्श robots.txt फाइल नहीं होता है।

इस फाइल को हम खुद से ऑप्टिमाइज करते हैं और एक Perfect robots.txt फाइल बनाते हैं क्योंकि ये हमारे Blog SEO के लिए बहुत महत्वपूर्ण होता है।

इस पोस्ट में हम SEO के लिए एक आदर्श robots.txt फाइल बनाना सीखेंगे, लेकिन इससे पहले हम थोड़ा ये समझ लेते हैं कि आखिर ये robots.txt file होता क्या है।

ये भी पढ़ें:- htaccess File cPanel और Filezilla में नहीं दिख रही है क्या करें

Robots.txt File क्या है?

robots.txt एक फाइल का नाम होता है जिसके अंदर ऐसे text या कोड होते हैं जो Search Engine को ये बताते हैं कि हमारे साइट के कौन से हिस्से को वो Crawl करें और कौन से हिस्से को क्रॉल ना करें।

क्योंकि सभी सर्च इंजन हमारे साइट के लिए एक Crawl Budget बनाते हैं उदाहरण के लिए आपके ब्लॉग पर 10 पोस्ट है तो सर्च इंजन 10 यूआरएल को कॉल करने का बजट बना देगा।

जब अगली बार Search Engine के Crawler आपके साइट पर Crawl करने के लिए आएगा और आप एक आदर्श robots.txt फाइल नहीं बनाए हैं तो फिर वो आपके साइट पर प्लगइन या अन्य बेकार चीजों को कॉल करके 10 यूआरएल पूरा कर देगा और जो उपयोगी पोस्ट है वो क्रॉल ही नहीं हो पाएगा।

और जब उपयोगी पोस्ट Crawl नहीं होंगे तो फिर वो Deindex हो जाएंगे और आपके साइट पर Traffic का बड़ा नुकसान होगा।

इसलिए हम एक Perfect robots.txt फाइल बनाकर सर्च इंजन को ये बताएंगे कि वो हमारे साइट पर जो बेकार चीजें है जिसको Crawl करने की कोई आवश्यकता नहीं है उसे क्रॉल ना करें और जो उपयोगी पोस्ट है उसे ही क्रॉल करें।

ये भी पढ़ें:- Publish Your Seller Information In The Google Sellers.json File

Robots.txt File की आवश्यकता कब होती है?

अगर आप robots.txt file नहीं बनाते हैं तो भी सभी सर्च इंजन आपके Blog को Crawl करेंगे लेकिन फिर आप उनको ये नहीं बता पाएंगे कि आपके साइट के किस हिस्से को क्रॉल करना है और किस हिस्से को क्रॉल नहीं करना है।

अगर आपने अपना ब्लॉग अभी-अभी बनाया है और उस पर ज्यादा पेज नहीं है तो फिर वो बिना robots.txt फाइल के भी चल सकता है इस फाइल की हमें तब जरूरत होती है जब हमारे ब्लॉग पर कुछ पोस्ट आ जाते हैं और फिर हम इस फाइल के मदद से अपना crawling budget को सेट करते हैं।

robots.txt फाइल के मदद से हम अपने साइट पर जरूरी पेज को Crawl करने के लिए सेट करते हैं और फिर हमारा crawling budget उपयोगी पेज पर इस्तेमाल किया जाता है।

हमारे साइट पर robots.txt फाइल के ना होने के वजह से Search Engine के Crawler एक बार में आपके साइट को क्रॉल नहीं कर पाते हैं और फिर इसके लिए बार-बार आते हैं और इस प्रक्रिया में हमारा साइट का Loading Speed भी धीमा हो सकता है।

इसलिए भी हम अपने साइट पर robots.txt फाइल बनाकर Crawler को ये बता देते हैं कि आप सिर्फ इन्हीं उपयोगी पेज को क्रॉल करो बाकी के हिस्से को क्राॅल ना करो और फिर ऐसे में आपका पूरा साइट एक ही बार में क्राॅल हो जाता है।

ये भी पढ़ें:- Sabse Achha Hosting कैसे चुने – Shared VS Cloud

एक आदर्श robots.txt फाइल कैसा होता है?

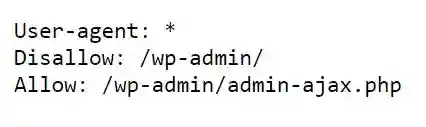

WordPress के द्वारा बनाया गया एक साधारण robots.txt फाइल इस प्रकार होता है।

ये फाइल Search Engine के Bots को आपके पूरी वेबसाइट जिसमें प्लगइन भी होते हैं Crawl करने की अनुमति देती है लेकिन हम अपने Crawl कोटा को बचाने के लिए अपने साइट के कुछ हिस्से को क्रॉल करने की अनुमति नहीं देंगे इसके लिए इस फाइल को ऑप्टिमाइज करेंगे।

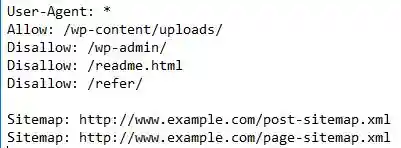

एक आदर्श या Perfect robots.txt फाइल इस प्रकार हो सकता है।

ये File सर्च इंजन के robots को वर्ल्डप्रेस इमेज एवं फाइल को Index करने के लिए बोल रहा है एवं वर्डप्रेस एडमिन एरिया और readme फाइल और Affiliate Link को Crawl एवं इंडेक्स करने से रोक रहा है और ऐसा ही होना भी चाहिए तभी हमारा क्रोल बजट उपयोगी पोस्ट के लिए बचा रहेगा।

हमने इस robots.txt फाइल में Sitemap के लिंक भी एड कर दिया है ताकि सर्च इंजन के बोट्स आपके साइट के सभी पेज को आसानी से ढूंढ सके और उसे Crawl और Fasr Index कर सकें।

कुछ नए Blogger को ऐसा लगता है कि एक बार वो पोस्ट लिखकर पब्लिश करते हैं और उसका लिंक सर्च कंसोल में डालकर इंडेक्स करा लेते हैं और फिर काम हो गया।

लेकिन ऐसा कतई नहीं है उस समय तो वो पोस्ट Index हो जाता है लेकिन जब दोबारा सर्च इंजन के bots आपके साइट पर आते हैं और वो पेज उन्हें नहीं मिलता है तो फिर वो पेज दोबारा से Deindex हो जाता है।

इसलिए अभी हमें robots.txt फाइल को आदर्श तरीके से बनाना है एवं उसमें साइटमैप के url जोड़ना आवश्यक होता है।

ये भी पढ़ें:- Blog Ko Rank Kaise Kare Google में Top Rank

WordPress में Robots.txt File कैसे बनाएं?

अगर आपने अभी तक अपना WordPress Blog के लिए robots.txt फाइल नहीं बनाया है तो वर्डप्रेस ने हीं शुरुआती में आपके ब्लॉग के लिए डिफ़ॉल्ट रूप से एक साधारण फाइल बना दिया होगा।

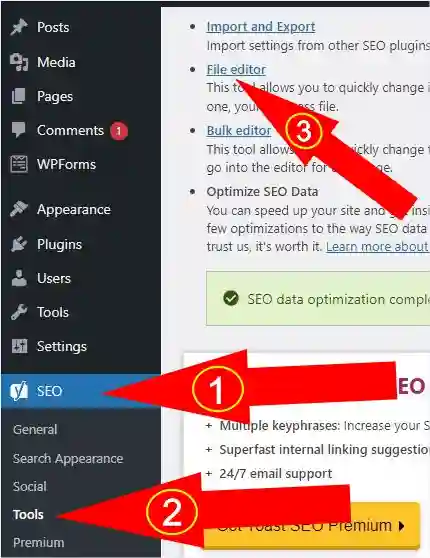

लेकिन अब हम खुद से Yoast SEO प्लगइन के मदद से एक आदर्श robots.txt फाइल बनाएंगे इसके लिए सबसे पहले आप अपने वर्डप्रेस एडमिन पैनल में लॉगिन करें।

अगर आपने अभी तक Yoast SEO Plugin को इंस्टॉल नहीं किया है तो इसे प्लगइन वाला सेक्शन में जाकर इंस्टॉल कर लें।

और फिर अब आपके वर्डप्रेस एडमिन पैनल में बांए साइड में नीचे के तरफ SEO का एक आइकन दिखेगा इसके ऊपर क्लिक करें और फिर Tool इस ऑप्शन पर क्लिक करें और फिर दाहिने साइड में File Editor के लिंक पर क्लिक करें। (नीचे चित्र देखें)

File Editor के लिंक पर क्लिक करते ही आपके सामने एक Create robots.txt का बटन आ जाएगा।

अब Create robots.txt के बटन पर क्लिक करें और फिर आपके सामने एक डिफ़ॉल्ट रूप से बना हुआ robots.txt फाइल दिखेगा। (नीचे चित्र देखें)

अब हम इस डिफ़ॉल्ट रूप से बना हुआ robots.txt फाइल को सेव नहीं करेंगे अभी इसमें बदलाव करेंगे और फिर सेव करेंगे।

इस फाइल में बदलाव करने के लिए इस बॉक्स के अंदर लिखे हुए सभी Text को डिलीट कर दें और नीचे दिए गए Text को नोट करके बॉक्स में टाइप करें।

ध्यान रहे नीचे Sitemap के दोनों यूआरएल को डिलीट करके आप अपना पोस्ट एवं पेज के साइटमैप के यूआरएल डालें, और अगर आपने अभी तक साइटमैप नहीं बनाया है तो बनाने के लिए इस गाइड को पढ़ें। XML Sitemap Kaise Banaye.

और फिर इस robots.txt फाइल को सेव करने के लिए नीचे Save Changes to robots.txt के बटन पर क्लिक कर दें।

अब आप अपने साइट के लिए एक आदर्श robots.txt फाइल बना लिया है अब हम इसे चेक करेंगे।

ये भी पढ़ें:- Solve Indexing Issue in Google

Robots.txt File को Test करना

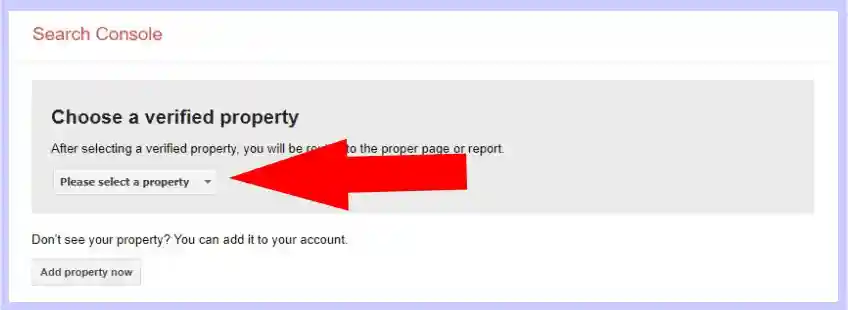

Robots.txt File को Test करने के लिए आप गूगल सर्च कंसोल के इस टूल को अपने ब्राउज़र में ओपन करें Robots Testing Tool.

और अब आप यहां पर please select a property के बटन पर क्लिक करके अपना उस प्रॉपर्टी को चुने जिसका robots.txt फाइल को टेस्ट करना चाहते हैं। (नीचे चित्र देखें)

प्रॉपर्टी को चुनते हैं आपके सामने आपके साइट का robots.txt फाइल दिख जाएगा जिसे आपने अभी-अभी बनाया था।

आप अपने robots.txt e-file को लाइव देखने के लिए एक दूसरा तरीका अपना सकते हैं इसके लिए आप अपने ब्राउजर में अपना डोमेन नेम टाइप करने के बाद robots.txt टाइप करें और फिर सर्च करें उदाहरण के लिए example.com/robots.txt

ऐसे करके आप किसी भी साइट के robots.txt file को चेक कर सकते हैं।

ये भी पढ़ें:- What is 404 Error and How To Fix it

और अंत में

हम robots.txt फाइल को इसलिए ऑप्टिमाइज करते हैं ताकि जिसे हम सार्वजनिक करना नहीं चाहते हैं उसे Crawl और Index होने से रोकें जैसे plugin फोल्डर के पेज या वर्डप्रेस एडमिन फोल्डर के पेज इत्यादि।

कुछ लोग अपने robots.txt फाइल में कैटेगरी एवं टैग को भी disallow करते हैं लेकिन यह उचित नहीं होता है इसके लिए कुछ दूसरे उपाय होते हैं।

हमें उम्मीद है इस पोस्ट How to Optimize WordPress Robots.txt File for SEO को पढ़कर आपने SEO में सुधार करने के लिए WordPress robots.txt फाइल को ऑप्टिमाइज कर लिया होगा।

अगर अभी भी आपके पास इस पोस्ट से संबंधित कोई सवाल है या आप अपना विचार हमें बताना चाहते हैं तो नीचे कमेंट बॉक्स में जरूर लिखें

नमस्ते मेरा नाम सुशील है और ये है Sushiltechvision.com यहां पर आपको Blogging, Online Earning, Earnings Aaps, Aadhaar Card, Pan Card इत्यादि से जुड़ी सभी जानकारी हिंदी में मिलेंगे, इस Hindi Blog से जुड़े रहने के लिए इसे सब्सक्राइब जरूर करें। धन्यवाद